Como ter um site faz seu negócio prosperar?

17 de março de 2021Como a história da SEO transformou o conteúdo da internet

A história da SEO (Otimização para mecanismos de busca) confunde-se um pouco com a da própria internet como a usamos na atualidade. Ela transformou ao longo dos anos a forma como compartilhamos e encontramos os mais variados temas nas páginas de resultados de busca (SERPs).

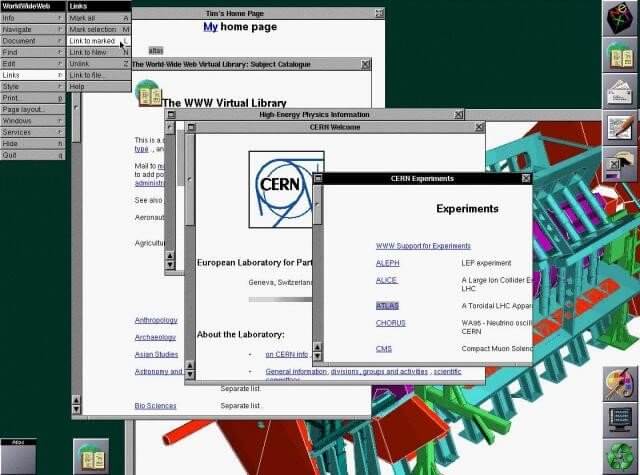

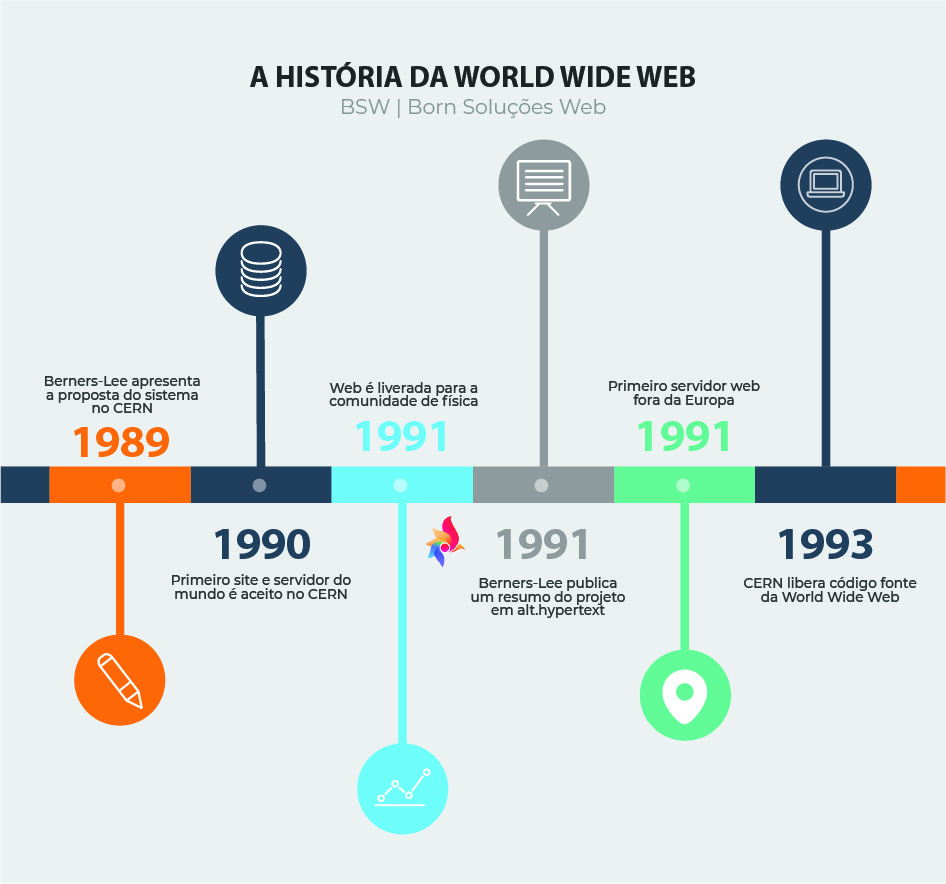

Desenvolvido pelo físico britânico Tim Berners-Lee, criador da W3 (World Wide Web), nosso famoso WWW, o primeiro site da história da internet como a conhecemos hoje, foi lançado em 06 de agosto de 1991. Veja aqui.

Desde a década de 1960, computadores americanos já trocavam dados via linha telefônica. Porém, o padrão de “HyperText Transfer Protocol” (HTTP), foi lançado em dezembro de 1990, pela CERN (Organização Européia de Pesquisa Nuclear), na Suíça.

Inicialmente, somente seus pesquisadores tinha acesso àquela tecnologia. Em 06 de agosto de 1991 seu conceito foi apresentado a diversos 'newsgroups'. Além disso, Berners-Lee também deu origem ao primeiro navegador e aos conceitos básicos dos protocolos de transmissão e da linguagem de programação HTML.

Segundo ele, como qualquer pessoa poderia ter feito o que ele fez, optou por não patentear sua criação. Era um conceito comum entre os desenvolvedores mais antigos, que acreditavam no que chamamos hoje de Open Source (Código Aberto).

Ainda segundo ele, a propagação da web se deu pela contribuição de muitas pessoas, o que não justificaria patentear a ideia como sendo exclusivamente sua.

Em janeiro de 2021, conforme dados anuais da Global Overview Report (Digital 2021), temos 4,66 bilhões de usuários da internet, sendo 5,22 bilhões de usuários únicos de dispositivos móveis.

Tivemos um aumento de 7,3% nos usuários de internet em relação a 1% sobre o crescimento populacional. Se você está se perguntando o que isso tem a ver com a SEO, vai entender ao longo desse artigo.

O que vamos abordar:

Mais história da SEO

Buscadores que precedem o Google

O Google Search

Por que usar “a” SEO e não “o”?

Como eram as métricas antigas de SEO

O que mudou na SEO de 2015 pra cá (2021)?

Lista de verificação para visibiliade básica nas pesquisas

- White, Gray e Black Hat: uma breve explicação

Conclusão

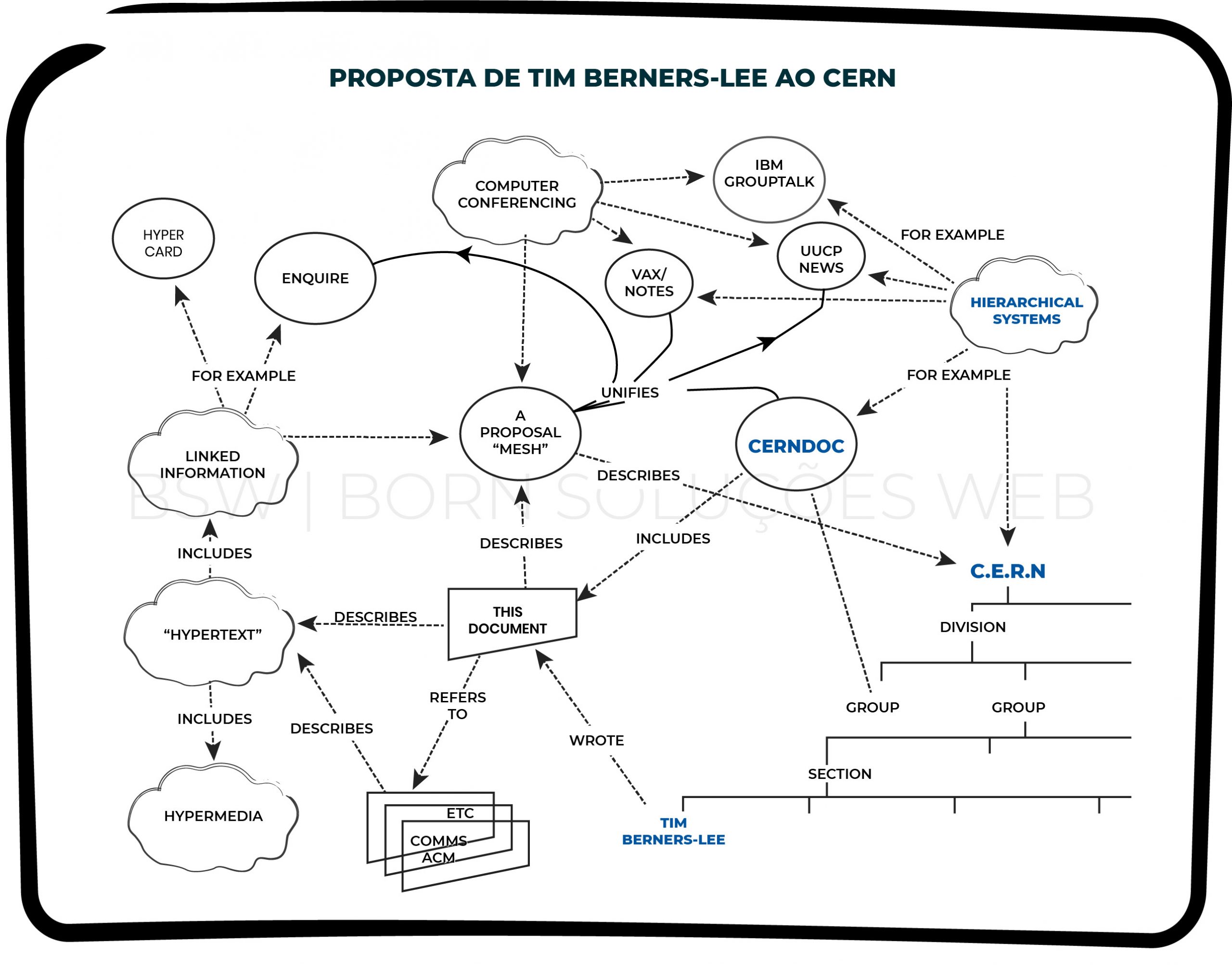

Proposta de Berners-Lee para o sistema de internet apresentado ao CERN

Registro de 1994 do CERN, quando a web já contava com mais de 10 milhões de sites

1. O que é a SEO?

A Otimização para Mecanismos de Busca (ou pesquisa) é um conjunto de técnicas, ferramentas e estratégias que potencializam a possibilidade de um site ou página web em alcançar posicionamento nas páginas de resultados em mecanismos de pesquisa, denomidas de SERPs.

É através da junção de dezenas de atributos relacionados à forma como os algortimos de busca operam para visitar e indexar o conteúdo é que um site poderá ser catalogado em seus índices e considerado relevante para elevar sua posição nas pesquisas orgânicas.

De acordo com o Glossário da Google, a SEO é “o processo de tornar seu site melhor para os buscadores”. E ainda: “Também o cargo de uma pessoa que faz isso para viver: Acabamos de contratar um novo SEO para melhorar nossa presença na web”.

Mais adiante entederemos a diferença entre o uso de “a” e “o” junto ao termo.

2. Mais história da SEO

A SEO surgiu, de acordo com os registros, em 1997. Existem três vertentes distintas sobre sua origem. A primeira é relatada no livro Net Results: Web Marketing That Works (lançado em 1998), onde Bob Heyman e Leland Harden teriam definido verbalmente o termo.

Na segunda, Danny Sullivan menciona que o termo Search Engine Optimization aparece numa publicação na Usenet em 26 de julho de 1997.

Porém, na terceira e mais concreta versão, a empresa de John Audette (Multimedia Marketing Group) já tinha páginas web no início de 1997 que mencionavam o termo Search Engine Optimization.

Antes da criação da Google, existiam buscadores que rastreavam as páginas da web e retornavam os resultados. Alguns exemplos são o Yahoo (lançado em 1994), que possuiu a liderança durante muitos anos mesmo depois do buscador de Larry Page e Sergey Brin; AOL e Altavista.

Porém o processo de catalogar essas informações estava em desenvolvimento e esbarravam nas limitações técnicas da época para o armazenamento do gigantesco volume de dados.

COMO COMEÇOU O RASTREAMENTO DE CONTEÚDO

No Stanford InfoLab Publication Server você encontra o artigo Efficient Crawling Through URL Ordering, de 1998, que aponta em seu abstract:

“In this paper we study in what order a crawler should visit the URLs it has seen, in order to obtain more "important" pages first. Obtaining important pages rapidly can be very useful when a crawler cannot visit the entire Web in a reasonable amount of time. We define several importance metrics, ordering schemes, and performance evaluation measures for this problem. We also experimentally evaluate the ordering schemes on the Stanford University Web. Our results show that a crawler with a good ordering scheme can obtain important pages significantly faster than one without.”

Tradução:

Neste artigo, estudamos em que ordem um rastreador deve visitar os URLs que viu, a fim de obter primeiro as páginas mais "importantes". Obter páginas importantes rapidamente pode ser muito útil quando um rastreador não pode visitar toda a Web em um período de tempo razoável. Definimos várias métricas de importância, esquemas de pedidos e medidas de avaliação de desempenho para este problema. Também avaliamos experimentalmente os esquemas de pedidos na Web da Universidade de Stanford. Nossos resultados mostram que um rastreador com um bom esquema de ordenação pode obter páginas importantes significativamente mais rápido do que um sem.

Os mecanismos de busca são bancos de dados que armazenam as páginas encontradas em cache, palavra que em tradução1 literal significa:

CACHE (kaesh) s, esconderijo para provisões.

CACHE (kaesh) v, esconder, ocultar (provisões)

No dicionário Aurélio da Língua Portuguesa, 5ª edição, compõe o seguinte significado:

cache [kæʃ] [Ingl., f. red. de cache memory, do ingl. cache, 'depóstio secreto' (fr. cacher, 'esconder') + ingl. memory, 'memória'.] S. m. Inform. Dispositivo de memória, de capacidade reduzida e alta velocidade, que funciona associado a um dispositivo de armazenamento de grande capacidade, porém mais lento, mantendo cópia temporária de dados acessados com mais frequência ou mais recentemente, com objetivo de agilizar o processamento de taus dados. [Cf. cachê e cachés]

Os rastreadores fazem a verredura nos mais de 1,2bi de sites existentes e, de acordo com as disponibilidades de tempo de retorno, velocidade, incluindo outros fatores técnicos dos servidores web, indexa e armazena uma cópia das páginas existentes para disponibilizar ao usuário que realiza a busca.

É importante salientar que as buscas são realizadas basicamente em formato de texto. Mesmo os diferentes algortimos para pesquisa de imagens e vídeos contam com a sua indexão baseadas neste formato e em metadados embutidos.

Isso torna, de certa forma, as pesquisas mais rápidas. Porém, devido ao volume de dados e a quantidade de sites existentes hoje, existe o projeto Memex da DARPA (Defense Advanced Projects Agency), para desenvolver uma nova maneira de indexar todo o conteúdo da internet, inclusive da deep web.

Na mesma pesquisa, cita-se:

Crawling takes time, so at some point the crawler may need to start revisiting previously scanned pages, to check for changes. This means that it may never get to some pages. It is currently estimated that over 600GB of the Web changes every month [Kahle 1997].

Tradução:

O rastreamento leva tempo, portanto, em algum ponto, o rastreador pode precisar começar a revisitar as páginas digitalizadas anteriormente para verificar se há alterações. Isso significa que pode nunca chegar a algumas páginas. Atualmente, estima-se que mais de 600 GB da Web mudam a cada mês [Kahle 1997].

A análise da relevância de conteúdo para os buscadores ainda era primária e não possuía os parâmetros que temos baseados na inteligência artificial (AI).

Os principais rastreadores da época dessa pesquisa eram: Altavista, InfoSeek, Excite, Lycos e Yahoo. Alguns, ainda que sem expressividade, estão em operação como o Lycos.

O Altavista foi um dos principais concorrentes entre os buscadores até o Google iniciar a conquista de sua hegemonia. No ano 2000, o Altavista chegou a alcançar 20% do mercado de buscas. Com o rápido crescimento da gigante da tecnologia, suprimiu a maioria dos concorrentes ao longo dos anos.

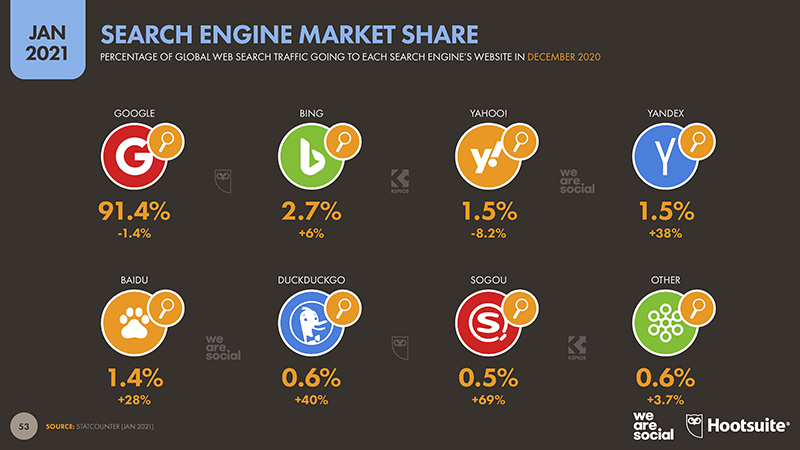

Até março de 2013, o Google tinha 66,7% do mercado, o Bing 17,4% e o Yahoo! ainda detinha 11,9%. Dados de janeiro de 2021 apontam para: Google 91,4% (-1,4%); Bing 2,7% (+6%); Yahoo 1,5% (-8,2%); Yandex 1,5% (+38%); Baidu 1,4% (+28%); Sogou 0,5% (+69%); Outros 0,6% (+3,7%).

Até mesmo os anúncios online são impactados pelos dados gerados organicamente. Contudo, é preciso entender que não é possível comprar posicionamento orgânico.

Trataremos desse tópico mais a frente.

Dados da Digital Overview Report 2021 sobre o sistemas de busca mais usados

O INÍCIO DA INTERNET E A CHEGADA DOS BUSCADORES

Para compreender o início das buscas online e a própria SEO como a poderosa ferramenta que temos na atualidade é preciso, primeiro, entender como chegamos até aqui.

Com o objetivo primordial de compartilhar informações e estreitar as comunicações entre seus colegas cientistas, Tim Berners-Lee usou o seu projeto ENQUIRE (de 1980) usado na CERN (Organização Européria para a Investigação Nuclear, Suíça), para elaborar um sistema de informação mais elaborado que pudesse gerenciar de forma mais eficaz essas informações.

Em 1989, ele escreve um nova proposta junto com Robert Caillliau e formaliza a World Wide Web (WWW), no final do ano de 1990.

Usando um computador NeXTcube como o primeiro servidor web e servidor HTTP (Protocolo de Transferência de Hipertexto), ele escreveu também a linguagem de marcação de hipertextos (HTML).

Este conceito de hipertexto vinha de outros projetos existentes desde a década de 1960, como Xanadu e NLS. Desenvolveu também o sistema de idenficação globla e único de recursos, o URI (Uniform Resource Identifier).

Nos sistemas anteriores as ligações eram bidirecionais, ou seja, os computadores (ou seus servidores locais) eram conectados um ao outro diretamente por linha telefônica.

Linha do tempo da fundação da World Wide Web

3. BUSCADORES QUE PRECEDEM O GOOGLE

Antes de existirem as nomenclaturas e políticas para SEO, os sistemas de busca não possuíam classificação de conteúdo, apenas mostravam os resultados de acordo com a indexação catalogada ou o mais recente disponível conforme as plavras-chave.

ARCHIE

Para surpresa de muitos, o primeiro sistema de pesquisas não era baseado na web, mas em FTP (File Transfer Protocol), o Protocolo de Transferência de Arquivos. O Archie Query Form foi desenvolvido por Alan Emtage, estudante canadense de pós-graduação da Universidade McGill, de Montreal, Canadá.

O projeto iniciado em 1987, contava com Peter Deutsch e Bill Heelan para conectar a Escola de Ciência da Computação da instituição à internet. Disponibilizado em 1990, o Archie ainda opera e teve sua última alteração em 2017.

WANDEX

Considerado o primeiro motor de buscas para a web, o World Wide Web Wanderer, era baseado em linguagem de programação Perl, lançado em junho de 1993 para medição do tamanho da World Wide Web.

Criação do aluno do MIT (Massachussets Institute of Technology), Mathew Gray, o rastreador foi usado posteriormente para gerar um índice chamado Wandex.

Mathew foi engenheiro de software da Google até 2017.

WEBCRAWLER

Inicialmente um aplicativo desktop da Universidade de Washington, em 15 de março de 1994, gerou uma lista com os 25 principais sites.

Em 20 de abril de 1994 foi lançado com 4 mil sites em seu banco de dados. Foi o primeiro site de pesquisa na internet onde todo o texto de cada página foi indexada pela primeira vez.

EXCITE

Em 1993, sob o nome de Architext, Graham Spence, Mark Vanharen, Ben Lutch e Martin Reinfried, alunos da Universidade de Stanford, pretendiam cirar um software que gerenciasse as informações da World Wide Web.

Após investidores apoiarem o grupo, o Excite foi lançado em outubro de 1995. Jornalistas escreviam breves comentários sobre os sites e, com isso, pretendiam aprimoramento da usabilidade em relação aos diretórios até então usados baseados em links.

Foram a versão mais próxima do que utilizamos hoje em termos de busca, pois os usuários precisavam apenas digitar o termo desejado para que a busca fosse realizada nas páginas que continham a expressão mencionada. Atualmente suas pesquisas são baseadas no Bing.

YAHOO

Com sua empresa fundada em janeiro de 1994 por Jerry Yang e David Filo, o buscador Yahoo despontou por anos como o principal mecanismo de pesquisa e teve papel importante na implementação da SEO no mercado.

O nome dado por Jerry inpirado no povo Yahoo, “rude e imperfeito”, parafraseava As viagens de Gulliver, obra de Jonathan Swift. Possui ainda a característica de retro-acrônimo, por ser derivada de outro acrônimo, como Yet Another Hierarchical Oracle (Mais um oráculo hierárquico).

Foram também Jerry e David os pioneiros na associação dos mecanismos de busca e da publicidade, disponibilizando banners do Yahoo em 1995, para monetizar e respaldar os investidores que conseguiram.

Sendo o primeiro guia online de navegação na Web, atualmente é um portal com vasto conteúdo e serviços como ferramentas de sites e hospedagem de lojas virtuais.

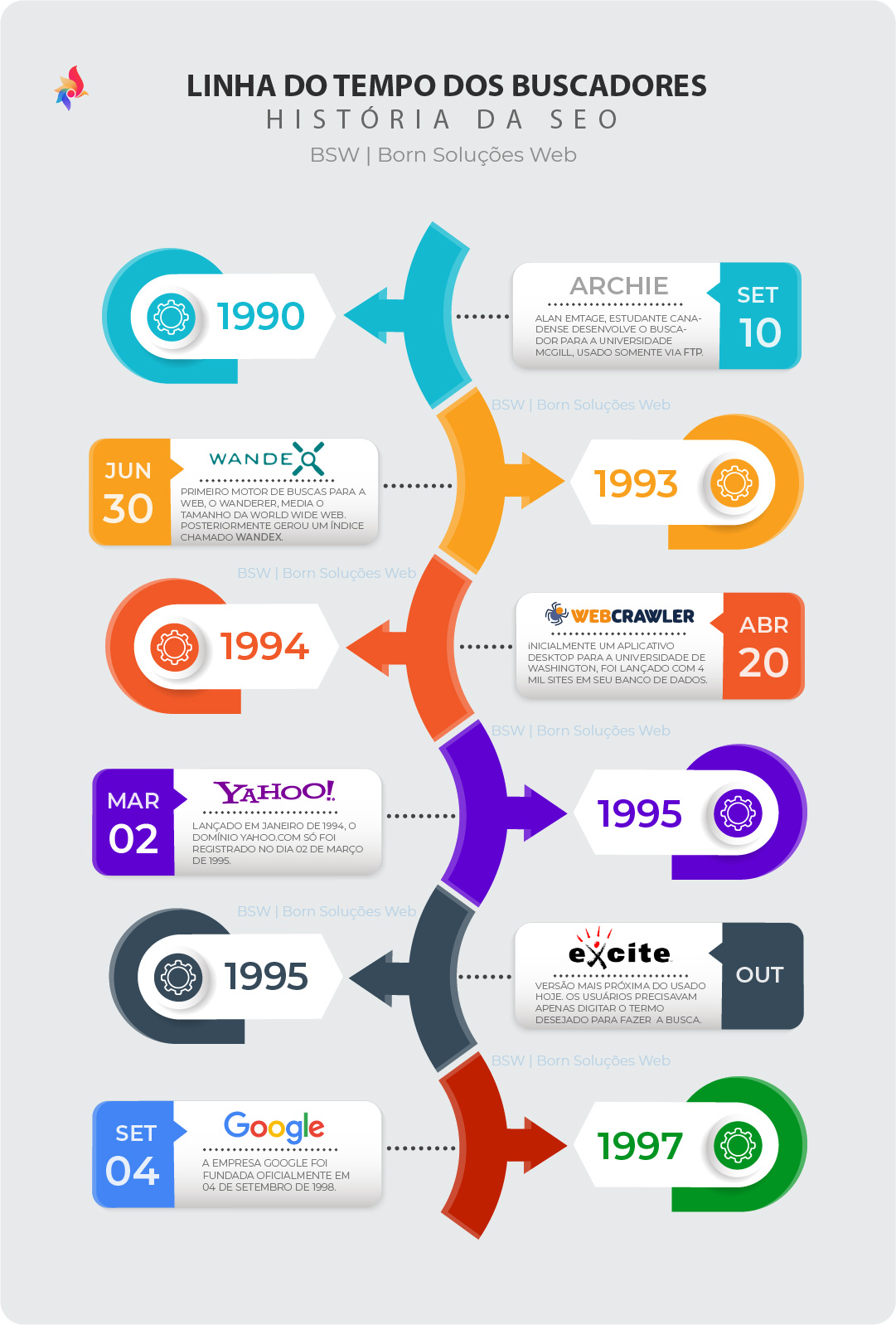

Linha do tempo dos primeiros buscadores da web - 1990 a 1997

4. O GOOGLE SEARCH

Os Google Guys Larry Page e Sergey Brin, lançaram sua obra-prima com o registro do domínio em 15 de setembro de 1997 e em 04 de setembro de 1998 fundaram a empresa que consolidaria o mercado digital mundial.

O projeto começou em 1996 enquanto cursavam doutorado na Universidade de Stanford. Na época, os motores de busca baseavam-se no número de vezes que um termo aparecia na primeira página. Idealizaram um sitema onde as relações entre os sites eram analisadas.

GOOGLE PAGERANK

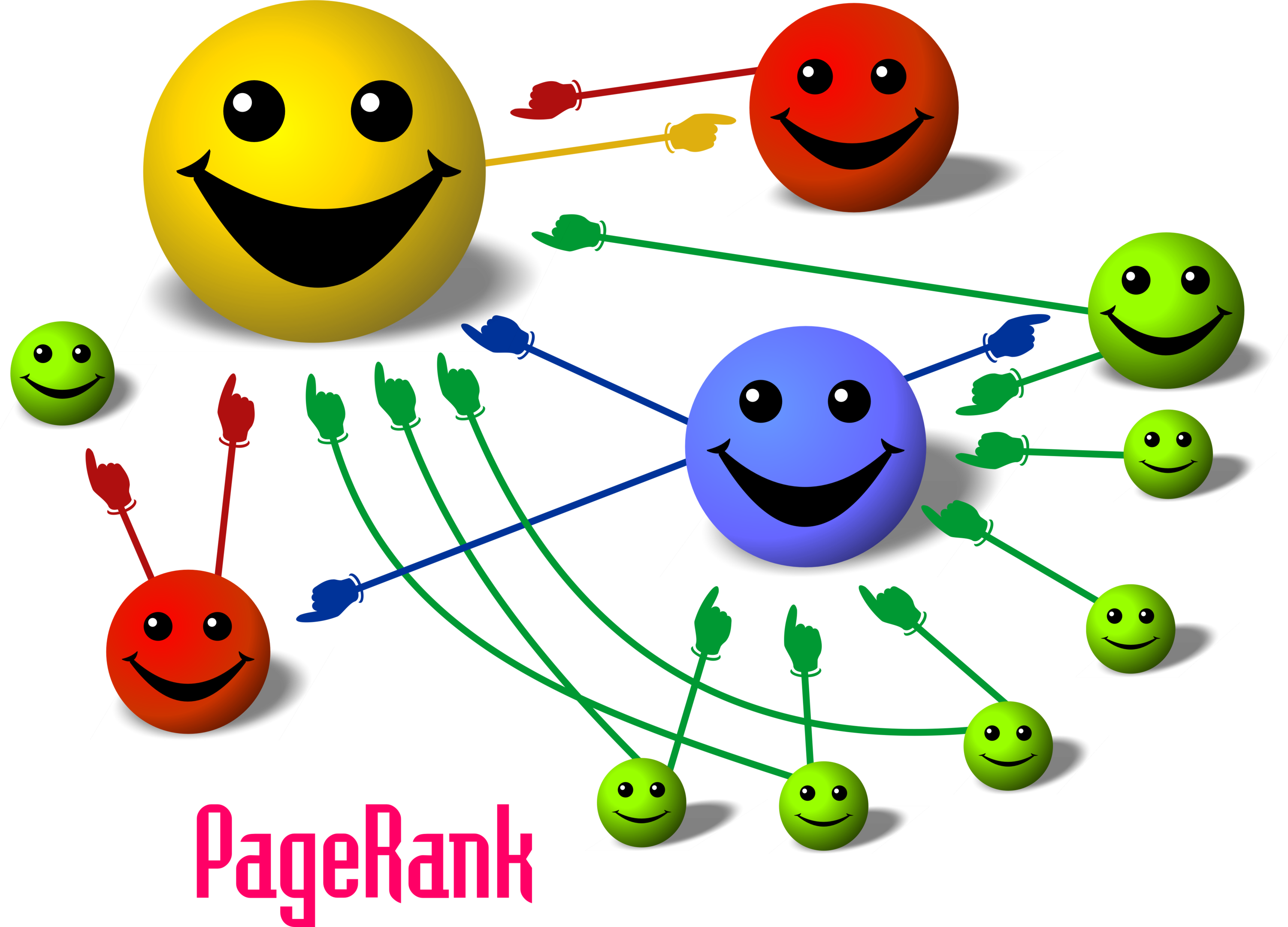

Quando se fala em SEO, é impossível não falar de PageRank. Tema de discussões infindáveis por profissionais otimizadores para mecanismos de buscas há mais de 20 anos, ninguém consegue, com absoluta certeza, precisar como funciona o algoritmo além das explanações contidas no artigo original.

Page e Brin desenvolveram e batizaram sua tecnologia de PageRank, para determinar a relevância dos sites conforme o número de páginas de um site e a importânia delas, assim como por ligação de volta ao site original.

Baseia-se numa hierarquia de popularidade de ligações. Considera que uma página é mais importante se tiver mais hiperligações apontando para ela e se dá pelo número de votos que uma página recebe. Cada link que aponte praquela página, independente de onde esteja na web, é um voto. Teve co-autoria de Rajeev Motwani e Terry Winograd.

O primeiro artigo junto com o protótipo inicial do motor de busca do Google foi publicado em 1998, que descrevia suas métricas.

Foi inspirado pela análise de citações desenvolvida em 1950 por Eugene Garfield, na Universidade da Pensilvânia, além do método “Hyper Search”, de autoria de Massimo Marchiori, da Universidade de Pádua. Ainda em 1998, Jon Kleinberg publicou seu trabalho sobre HITS, sendo ele e Marchiori citados no artigo original dos fundadores da Google.

Métrica PageRank para os nós de uma rede simples, expressos em percentagens. (O Google usa uma escala logarítmica). O nó C tem um valor de PageRank mais elevado do que o nó E, apesar de existirem poucas ligações para C, a ligação para C vem de um nó importante e, portanto, tem um valor elevado. Se um utilizador começar num nó aleatório com uma probabilidade de 85% de escolher uma ligação aleatória a partir do nó que está a visitar no momento, e uma probabilidade de 15% de saltar para um nó escolhido aleatoriamente de toda a rede, esse utilizador vai chegar ao nó E 8,1% das vezes. (A probabilidade de 15% de saltar para um nó arbitrário corresponde a um fator de amortecimento de 85%). Sem amortecimento, qualquer utilizador acabariam nos nós A, B, ou C, e todos os outros teriam o valor zero para PageRank. Através da utilização do fator de amortecimento, o nó A está ligado a todos os nós da rede, mesmo que não tenha ligações para outros nós.

Curiosidade:

Neste percurso, Robin li desenvolvia desde 1996 um motor de busca muito similar com estratégia de pontuação e ranking de páginas chamado RankDex, patenteado em 1999. Mais tarde, Li utilizou a tecnologia ao fundar a Baidu na China.

Seu trabalho é referenciado por Larry Page em algumas patentes de métodos de pesquisa do Google.

O algoritmo do PageRank

Mesmo não sendo o único método de análise e pontuação do Google para a classificação das páginas e de seu conteúdo, admitem que ele é o coração de seu software, mencionado em sua página sobre o assunto:

Explicações sobre o PageRank

A classificação das páginas (PageRank) confia na natureza excepcionalmente democrática da Web, usando sua vasta estrutura de links como um indicador do valor de uma página individual. Essencialmente, o Google interpreta um link da página A para a página B como um voto da página A para a página B. Mas o Google olha além do volume de votos, ou links, que uma página recebe; analisa também a página que dá o voto. Os votos dados por páginas "importantes" pesam mais e ajudam a tornar outras páginas "importantes."

E ainda:

Integridade

Os sofisticados métodos de automação do Google tornam a manipulação de nossos resultados extremamente difícil. E, apesar de veicularmos alguns anúncios relevantes acima e ao lado dos resultados, o Google não negocia classificações dentro dos resultados de busca (ou seja, não é possível comprar uma posição privilegiada na Listagem de Páginas). A busca no Google é um meio fácil, honesto e objetivo de encontrar websites de boa qualidade com informações importantes para a sua pesquisa.

Logo, não pense que é possível burlar as regras e manipular os índices de classificação do Google usando técnicas de Black Hat SEO, que explanaremos de forma sucinta neste artigo.

Outro fator importante de ser compreendido são as melhores práticas para a criação de seu conteúdo, de links amigáveis, uso correto de metadados e dados estruturados, títulos únicos e objetivos, descrições precisas do conteúdo das páginas e navegação simples, visando uma SEO dinâmica, sistêmica.

Isso não apenas fará com que suas páginas sejam bem classificadas pelo algoritmo na avaliação da qualidade do seu conteúdo, mas tornará a legibilidade agradável para o usuário.

Imagine que você acessa o conteúdo de uma página e encontra um link que te interessa. Você clica nele e, contudo, não vai direto ao destino e sim a outra página que te redireciona para ele ou pior, para outra página.

Essa prática geralmente é penalizada, pois gerará um alto “índice de rejeição” das páginas. Este índice é medido pelo tempo que o usuário permanece na página. Caso permaneça menos de 30 segundos na página, poderá ser computado como um página rejeitada.

Quanto mais páginas altamente rejeitadas no seu site, pior será avaliada a qualidade e terá menos links a apontarem para ela, o que diminuirá ainda mais a qualificação.

A intenção em otimizar páginas para serem encontradas nas pesquisas dos buscadores é que sejam relevantes à pessoa que procura determinado conteúdo e consequentemente ela permaneça o tempo necessário para a visualização total.

Gerando conteúdo de qualidade e seguindo as boas práticas de SEO, a probabilidade é de que você consiga elevar sua posição gradativamente, podendo alcançar a primeira página, quiçá, a primeira posição no Google Search e em outros buscadores.

5. A INTERNET GIRA EM TORNO DOS BUSCADORES?"

“The best place to hide a dead body is the second page of Google search”.

O melhor lugar para esconder um corpo é na segunda página de buscas do Google.

Há mais de uma década, ou mais, vejo essa expressão circulando pela internet. Já vi atribuírem a expressão até a Bill Gates e Steve Jobs, mas até o momento de conclusão deste artigo, não encontrei autor conhecido correspondente.

Entretanto, tornou-se piada interna em meio aos profissionais de SEO. Eu discordo em partes dessa afirmação. É fato que a maioria avassaladora das pessoas não pesquisa na segunda página, muito menos da terceira em diante.

Só que você pode ter sim um site na segunda página ou até menos e ter resultados. Pode ocorrer também que nem todas as páginas do seu site alcancem a primeira páginda de buscas. E tudo bem com isso. É difícil mesmo.

Agora, se uma pessoa totalmente leiga em tecnologia te pedisse ajuda para aprender a navegar na internet, você a ensinaria primeiro a criar contas em mídias sociais? Curtir, compartilhar, usar o whatsapp, baixar e instalar programas em computadores e celulares ou pesquisar no Google?

Se você pensou em ensinar a “pesquisar no Google”, pensou completamente certo. Lá essa pessoa encontrará tudo o que precisa para todas as questões anteriores.

É a melhor maneira dessa pessoa conseguir encontrar respostas para suas dúvidas em todos os outros quesitos. Se ela quiser aprender uma receita nova para o jantar de família, vai achar não só uma receita, mas dezenas de milhares, milhões.

COMO A SEO PODE CRESCER SEU NEGÓCIO

O Google possui mais de 10 bilhões de páginas indexadas. E bota mais nisso. Alcançamos em janeiro de 2020, mais de 1,24bi de domínios registrados em todo o mundo.

Só no Brasil, os números oficiais do Registro.br (até 07/03/2021) apontam 4.604.393 registros de domínios. Em 2020, foram cerca de meio milhão de novos domínios registrados pelo órgão.

Estamos falando de SEO e nossa principal ferramenta são os mecanismos de busca. Vamos pensar nesses índices da Global Overview Report 2021:

-› 98% dos usuários entre 16 e 64 anos usaram mecanismos de busca em qualquer dispositivo;

-› 45,3% das buscas foram realizadas por comando de voz;

-›32,9% usaram reconhecimento de imagens na busca (Google Lens).

Se você chegou até aqui, então tem muito interesse em avaliar as possibilidades que a otimização para buscas pode fazer pelo seu negócio.

E se isso não te surpreende, saiba que 81,5% dessa mesma faixa etária fizeram buscas de produtos ou serviços para comprar, dentre os 4,66 bilhões de usuários globais da internet.

Falando de Brasil, temos 160 milhões de usuários de internet, sendo 75% dos 213,3mi de pessoas. Temos uma das maiores médias mundiais para a faixa de 16 a 64 anos passando em média 10h08m por dia na internet em 2020. E 96,1% desse público acessa a internet pelo celular.

Sabe o que isso quer dizer? São 143,9 milhões de usuários únicos acessando a rede mundial de computadores todos os dias.

Quem não está apostando em SEO para alcançar esse público, não faz ideia de quantas oportunidades está perdendo diariamente.

Você usa seu smartphone para acessar a internet? 95% dos 153,7mi de aparelhos móveis do Brasil acessam por este dispositivo.

Como eu trabalho com SEO, adoro dados. Eu os consumo diariamente em busca dessas oportunidades. Então lá vão mais alguns: 51% do tráfego total ocorre via celulares e 48,1% por computadores e laptops.

O ECOMMERCE E A IMPORTÂNCIA DA SEO

Mais uma vez, pense comigo no poder da otimização e como ela pode fazer seu negócio crescer usando o tráfego orgânico.

Se 91,4% dos usuários de 16 a 64 anos fizeram buscas por produtos ou serviços online através dos mecanismos de pesquisa no Brasil, 94,2% visitaram algum site de vendas, 79,4% usaram aplicativos de compras em dispositivos móveis, 76% compraram usando qualquer tipo de dispositivo e 50,8% compraram usando um aparelho móvel, por que razão você acreditaria que apenas com anúncios alcançaria todo o público potencial que poderia?

Tem ideia de quanto teria de investir para isso?

Mas já vou te avisando, contratar um especialista em SEO também não é barato. Se ele souber como unir as ferramentas analíticas que medem os dados de fluxo orgânico com os anúncios em plataformas como o Google Ads, será um investimento bem maior, porém ainda melhor.

Quando você usa corretamente as técnicas, ferramentas e estratégias de SEO para identificar e filtrar o público para o seu produto ou serviço, passa a ter um poder em suas mãos que outros negócios similares ao seu, definitivamente não têm.

Respondendo a pergunta deste tópico, A internet gira em torno dos buscadores? É um sonoro e ensurdecedor SIM.

6. POR QUE USAR “A” SEO E NÃO “O”

Você diz a otimização ou “o” otimização? É uma questão prática de usar a língua portuguesa corretamente.

Quando nos referimos ao termo SEO como ferramenta do marketing digital, o correto é referir-se “A” SEO, a otimização para mecanismos de busca (ou pesquisa).

Se estivermos falando sobre o profissional SEO, é “O” otimizador ou manter-se “A” otimizadora, em relação a pessoa. A semântica do português o torna uma linguagem objetiva. Por quê você está me dizendo isso Roberto?

Porque um dos fatores principais da ferramenta é a escrita. Embora hajam discrepâncias entre as normas do português e os métodos de escrita para a web, escrever bem é imprescindível.

Essas normas são essenciais para entender as diferenças entre escrever um parágrafo para uma redação, um documento acadêmico, artigo científico, um livro; e um artigo para blog, o texto das suas páginas.

Erros na escrita, tal qual nos citados anteriormente são mal vistos e mal interpretados pelos robôs rastreadores. A divisão de parágrafos, por exemplo, difere do que faríamos usualmente.

Todavia, mais importante é elucidar que o algoritmo precisa entender se o que está escrito realmente tem relação com o título da página ou da publicação, com as palavras-chave, descrição e metadados embutidos.

Ele analisa todo o contexto, não apenas o conteúdo literal.

7. COMO ERAM AS MÉTRICAS ANTIGAS DE SEO

E no princípio, houve a luz! (Rs)

Depois desse advento da comunicação, fluxo de dados e empoderamento comercial trazido pela internet, houveram vários marcos na transição de como fazíamos e como fazemos a otimização de sites para buscas.

Técnicas que há 10, 15, 20 anos eram consideradas white hat (permitidas), hoje não são mais. Por exemplo, ter um texto curto de 200 palavras em que 150 delas sejam a sua palavra-chave, é black hat. Um dia não foi.

A melhor maneira de fazer com que seu site posicionasse era usar algo do tipo:

Título: Conserto de Máquinas de Lavar

Você precisa de conserto de máquina de lavar?

Fazemos conserto de máquina de lavar. Conserto de máquina de lavar “marca x”, Conserto de máquina de lavar “marca y”... e da mesma forma as outras 10 marcas.

Nós buscamos a sua máquina de lavar em sua casa, Entregamos a sua máquina de lavar consertada de volta em sua casa.

Isso é o chamado “keyword stuffing” ou sobrecarga de palavras-chave. Se fizer isso hoje, pode até ter seu site banido dos sistemas de buscas.

Sim. Por vezes, caso o algoritmo identifique um comportamento anormal ou repetitivo em seu site, ele poderá cair em uma auditorial manual, principalmente no Google.

Caso seja comprovado o uso de técnicas que vão contra as políticas, robôs de navegação, sites duplicados, compra de links (fake backlinks), o domínio poderá receber banimento temporário ou permanente.

Exatamente. O domínio não voltará a aparecer em resultados de pesquisa, nunca mais. Então muito cuidado. Profissionais de SEO sérios e comprometidos com o sucesso do seu negócio não praticam esses tipos de técnicas.

8. O QUE MUDOU DE 2015 PRA CÁ

Neste artigo, não entrei com profudindade em todas as mudanças no algoritmo do Google, como a implementação do Google Florida, Panda, Penguin, Hummingbird, etc.

Resumindo, essas alterações – e elas são quase que diárias na plataforma – visam aprimorar a experiência dos usuários com as buscas.

O Hummingbird, por exemplo, entrou em vigor em 26 de setembro de 2013, visando velocidade e precisão. O nome derivado do beija-flor, dá ênfase a linguagem natural, com observância de contexto e o significado de palavras-chave individualmente.

Tivemos antes dessa, a atualização Caffeine, que reestruturou a arquitetura de buscas para melhorias em velocidade e indexação subjacente. Ocorreu em resposta a chegada do Bing pela Microsoft e do lançamento do Wolfram Alpha, buscador baseado em conhecimento computacional.

Com essa atualização, mudou também o sistema de indexão do MapReduce para o Bigtable, baseada na plataforma de banco de dados (NoSQL) distribuída da Google.

RANKBRAIN

Em 26 de outubro de 2015, um novo algortimo baseado em aprendizado de máquina (machine learning), o RankBrain, chega para processar e fornecer resultados de pesquisa ainda mais relevantes aos usuários.

Em entrevista oficial naquele ano a Google informou que “foi o terceiro fator mais importante no algoritmo de classificação junto com links e conteúdo”.

Se o RankBrain encontrar uma palavra ou frase com a qual não esteja familiarizado, pode adivinhar quais palavras ou frases podem ter siginificado semelhante para filtrar os resultados, sendo mais eficaz em consultas de pesquisa ou palavras-chave nunca vistas antes.

Literalmente, o algoritmo do Google aprende através da linguagem natural o que o usuário quer, filtra essas informações junto com as do seu padrão de comportamento, as informações de seu bando de dados e te retorna consultas personalizadas como nunca havia tido antes.

MEDIC (ETA - Especialização, Reconhecimento e Confiança)

Agosto de 2018. Danny Sullivan anuncia uma atualização de algoritmo de núcleo. A atualização Medic visava remover sites médios e relacionados à saúde considerados não amigáveis e que não forneciam uma boa experiência do usuário.

As páginas YMYL (Your Money or Your Life), seu dinheiro ou sua vida, são observadas com padrões muito restritos pela plataforma. Tanto que para as áreas de saúde usarem o serviço de anúncios, é necessário um formulário do Google e em caso de medicamentos, por exemplo, exige inclusive autorização especial da ANVISA para indústrias farmacêuticas e drogarias realizarem anúncios e vendas online.

Não tem essa de “eu tô pagando”.

Um exemplo que aconteceu comigo.

Em 2013, eu atendia a uma drogaria em Goiânia, Goiás. Fui contratado para gerenciamento das campanhas no Google Ads e enquanto eu verificava todos os critérios, elaborava o planejamento e fazia o relatório para informar ao cliente sobre os formulários necessários, ele ativou um anúncio que tinha começado a fazer e parou.

Resultado, a conta dele e a minha conta MCC foi suspensa temporariamente, com uma notificação de que a não resolução poderia gerar a suspensão permanente, incluindo o CNPJ do cliente, o meu e até o meu CPF. Eu não poderia mais anunciar no Google.

Nesse período, muitos sites que usavam informações médicas irrelevantes ou mesmo inverídicas, simplesmente para veiculação de anúncios e ganhos com o AdSense, tiveram seus domínios penalizados, suspensos ou banidos permanentemente do sistema de buscas do Google.

9. LISTA DE VERIFICAÇÃO PARA VISIBILIADE BÁSICA NAS PESQUISAS

A Central de Ajuda do Google Search Console possui um Guia de SEO para iniciantes e uma lista de verificação para visibilidade básica nas pesquisas.

Na realidade, informam que para que seu site apareça nas buscas, você precisa apenas tê-lo publicado e não possuir nenhuma restrição nos arquivos específicos que gerenciam tanto as recomendações do que rastrear (Robots.txt e Sitemap.XML) quanto no arquivo de segurança do seu servidor (.htaccess).

Apesar de minhas tratativas serem para sites em Wordpress em mais 99% dos casos, as configurações desses arquivos independem se você usa ele como CMS, o Drupal, Joomla, Magento ou outro dos vários disponíveis ou ainda, em HTML., PHP, Javascript, etc.

A seguir, o conteúdo é exatamente na íntegra, como fornecido na Ajuda do Search Console. Esses são pontos básicos que você deve checar para que tenha uma boa experiência com a exposição de suas páginas na plataforma.

Meu site está aparecendo no Google?

A inclusão nos resultados da Pesquisa Google é gratuita e fácil. Geralmente, você só precisa publicar seu site na Web. Para ver se suas páginas já estão indexadas, procure o site na Pesquisa Google usando uma consulta como esta:

site:example.com

Substitua seu site por "example.com". Se o site não aparecer, verifique a propriedade dele no Google Search Console e depois envie suas páginas para o Google.

O conteúdo que veiculo para os usuários é de alta qualidade?

Sua prioridade número um deve ser garantir que os usuários tenham a melhor experiência possível no seu site. Pense sobre o que faz seu site ser especial, valioso ou interessante. Leia as Diretrizes para webmasters do Google e gerencie seu site usando práticas otimizadas.

Minha empresa local está aparecendo no Google?

O Google Meu Negócio é uma ferramenta gratuita e fácil de usar que ajuda a gerenciar como informações comerciais aparecem no Google, inclusive na Pesquisa e no Maps. Considere adicionar sua empresa e seu site a google.com/business.

Meu conteúdo é rápido e fácil de acessar em todos os dispositivos?

A maioria das pesquisas agora é feita a partir de dispositivos móveis. Por isso, otimize seu conteúdo para que ele seja carregado com rapidez e exibido corretamente em todos os tamanhos de tela. Teste se as páginas são compatíveis com dispositivos móveis.

Meu site é seguro?

Os usuários modernos esperam ter uma experiência on-line segura. Use HTTPS para deixar a conexão do seu site segura.

É válido mencionar que o teste de compatibilidade das páginas com os dispositivos móveis é indispensável, devido a mais de 50% dos acessos ocorrerem através destes aparelhos.

A usabilidade, legibilidade e navegação móvel é um dos critérios mais importantes. Você deve estudar a implementação de recursos AMP (Acelerate Mobile Pages) e PWA (Progressive Web Apps) em seu site.

Após fazer todas as verificações, gerar o Sitemap.xml ou incluir suas páginas manualmente nas buscas, você deve esperar alguns dias até que os dados comecem a ser mensurados.

GOOGLE MEU NEGÓCIO

Apesar de muitas pessoas já conhecerem o Google Meu Negócio e até o utilizarem, existem muitos recursos e praticidade dele que não são exploradas.

É preciso o entendimento de que o desenvolvimento de sites e a gestão de tráfego orgânico (SEO) e pago (Anúncios) constituem-se de várias ferramentas digitais integradas.

Para obter resultados satisfatórios, será necessário o acompanhamento de um profissional. Apesar de haver uma vastidão de conteúdos gratuitos na internet, sugiro que você evite se aventurar sozinho nessa empreitada.

A não ser que disponha de todo o tempo do mundo para para aprender tudo o que é necessário, bem como aplicar esses conhecimentos. É uma demanda de tempo insana.

Detalhes minuciosos podem fazer a diferença entre ótimo posicionamento ou uma frustração interminável devido a quantidade de tarefas a serem executadas.

10. WHITE, GRAY E BLACK HAT: UMA BREVE EXPLICAÇÃO

Eu prometi que falaríamos sucintamente sobre o que é permitido e o que não é em SEO. O motivo é simples.

Discorrer em relação a essas técnicas gera outro artigo tão denso quanto este pra que possa concatenar desde o início o que era permitido e porquê não é mais, o que não era nem permitido nem proibido e migrou para um lado ou outro.

Desta afirmação anterior, estou falando das Gray Hat SEO. Vamos começar pelo começo.

WHITE HAT SEO

Essas são as técnicas permitidas validadas pelos buscadores. Pode ocorrer de existir alguma recomendação que seja obrigatória no Google e no Yandex, por exemplo, seja opcional.

Suponhamos que você crie o seu site e se esqueça de declarar o Título dele. A tag “Title” é orientada nas melhores práticas como sendo:

-» Descreva com precisão o conteúdo da página

Escolha um título que seja lido naturalmente e comunique com eficácia o tópico do conteúdo da página.

-» Crie títulos exclusivos para cada página

Cada página do seu site deve ter, idealmente, um título exclusivo, que ajude o Google a saber como a página é diferente das outras do seu site. Se o seu site usa páginas diferentes para celular, lembre-se de usar bons títulos nas versões para celular também.

-» Use títulos breves, mas descritivos

Os títulos podem ser curtos e informativos. Se o título for muito longo ou considerado menos relevante, o Google pode mostrar apenas uma parte dele ou uma que é gerada automaticamente no resultado da pesquisa. O Google também pode mostrar títulos diferentes, dependendo da consulta do usuário ou do dispositivo usado para a pesquisa.

<html> <head> <title>Brandon's Baseball Cards - Buy Cards, Baseball News, Card Prices</title> <meta name="description" content="Brandon's Baseball Cards provides a large selection of vintage and modern baseball cards for sale. We also offer daily baseball news and events."> </head>

Essas são apenas algumas das recomendações de boas práticas do Google que constam no Guia de SEO para Iniciantes. Usá-las e acompanhar as notificações, realizar diagnósticos periódicos, contínuos e, da mesma forma, as atualizações de conteúdo e otimização em seu site farão enorme diferença no posicionamento ao longo do tempo.

Mas lembre-se, a qualidade do conteúdo é mais importante que a quantidade. Mecanismos de busca não são como as mídias sociais que estão desesperadamente brigando por sua atenção (ou por distraí-la completamente) com toneladas de conteúdo diário.

Para o seu site, ou você foca em conteúdo estrutural, bem embasado, bem escrito ou crie apenas um site estático com as suas páginas principais e deixe o Blog para uma etapa em que você tenha recursos para investir no conteúdo ou tenha tempo.

GRAY HAT

São as técnicas que não são proibidas, mas também não são regulamentadas. Enquanto elas não são analisadas, testadas e verificadas pelas plataformas para identificar se produzem algum efeito negativo ou conseguem influenciar a pesquisa de modo que conteúdo de baixa qualidade passe pelos filtros, elas vão passando.

Caso seja confirmada qualquer violação das políticas por essas técnicas, elas entram na classificação de black hat.

O que sugerimos por prática é manter-se sempre dentro das práticas recomendadas, pois havendo restrição dessas práticas, o trabalho para correção é desgastante e pode gerar penalidade severas se não forem corrigidas em tempo hábil.

É melhore prevenir, sempre. Fazendo uso das white hat você não terá problemas.

BLACK HAT

Como já dito, são as práticas banidas, proibidas pelos sistemas de busca. Seu uso pode não ser identificado inicialmente. Contudo, não se engane.

Mais dia menos dia é possível cair numa auditoria manual. Ela é mais comum do que você possa imaginar.

Além das realizadas aleatoriamente, pode ocorrer de o algortimo identificar algo que gere a desconfiança de que seu site possa, por exemplo, usar robôs de navegação para gerar mais tempo de permanência e aumentar o índice de acessos.

O problema é que mesmo que haja um rodízio nessa automação, entenda que um robô reconhece outro.

Aí você já ficará sempre naquela “listinha meio cinza”. Se a probabilidade seria remota, tenha certeza de que ela ocorrerá incisiva e ostensivamente.

Ninguém quer perder o domínio, o site, dinheiro, tempo. O conteúdo que tenha usado nele, esqueça. É recomeçar do zero.

Geralmente nenhum profissional responsável entra em muitos detalhes sobre essas técnicas,. Sempre pode aparecer aquele aventureiro que paga pra ver.

Na dúvida, faça apenas o certo.

11. CONCLUSÃO

Aparecer nas buscas do Google ou de qualquer sistema de buscas usando as técnicas de otimização não tem mágica. Não é preciso um “guru” pra isso.

Existe uma diversidade de ferramentas analíticas, como o MOZ, Alexa, SEMrush, Ubersuggest, WooRank, Ahrefs. Algumas possuem versões gratuitas e outras somente pagas.

Eu aprendo e pratico a SEO desde 2003. Todos os dias eu aprendo algo novo, acompanho alguma atualização, leio a central de ajuda de uma das várias plataformas que utilizo, testo funcionalidades. São horas diárias de pesquisa.

Se alguém te disser que poucas horas de um curso mágico revolucionário você será o novo ultra mega máximo expert da Otimização para Buscas, pense bem.

Otimizar um site requer dedicação e atenção extremas. A recomendação que posso te dar é “comece do começo”, aprenda, teste, anote (de preferência papel e caneta).

Aprenda mais, teste mais, veja o que funciona pra você, analise outras empresas da sua área, use ferramentas de análise de dados, aprenda como gerar seus próprios relatórios de dados a partir do seu servidor web.

Isso te dará maior capacidade de percepção e um raciocínio lógico sobre como funciona o mercado digital.

Nada é definitivo. Criar um site não é o que eu chamo de “ad eternum”, fez está feito e é imutável. Talvez chegue o ponto de ter de revisar o seu site inteiro e fazer alterações em massa para cumprir os requisitos que mudam constantemente.

Serviço automatizado e SEO não combinam, jamais combinaram e creio, pela minha experiência, que é a “fórmula mágica da preguiça”.

Tráfego, seja orgânico ou pago, não é serviço pra quem nunca tem tempo ou morre de preguiça de se debruçar em estudos e pesquisas permanentes.

Você gostou do artigo? Então deixa aí seu comentário, pergunta ou sugestão para uma nova publicação.

Pode ter certeza que eu vou pesquisar até encontrar, analisar e redigir o tema desde o princípio a melhor atualidade, se for o caso.

1Novo Dicionário Ilustrado de Inglês